- updated time: 2024-08-17

-

ollama安装

-

网络环境良好

Terminal window curl -fsSL https://ollama.com/install.sh | sh -

网络环境较差

-

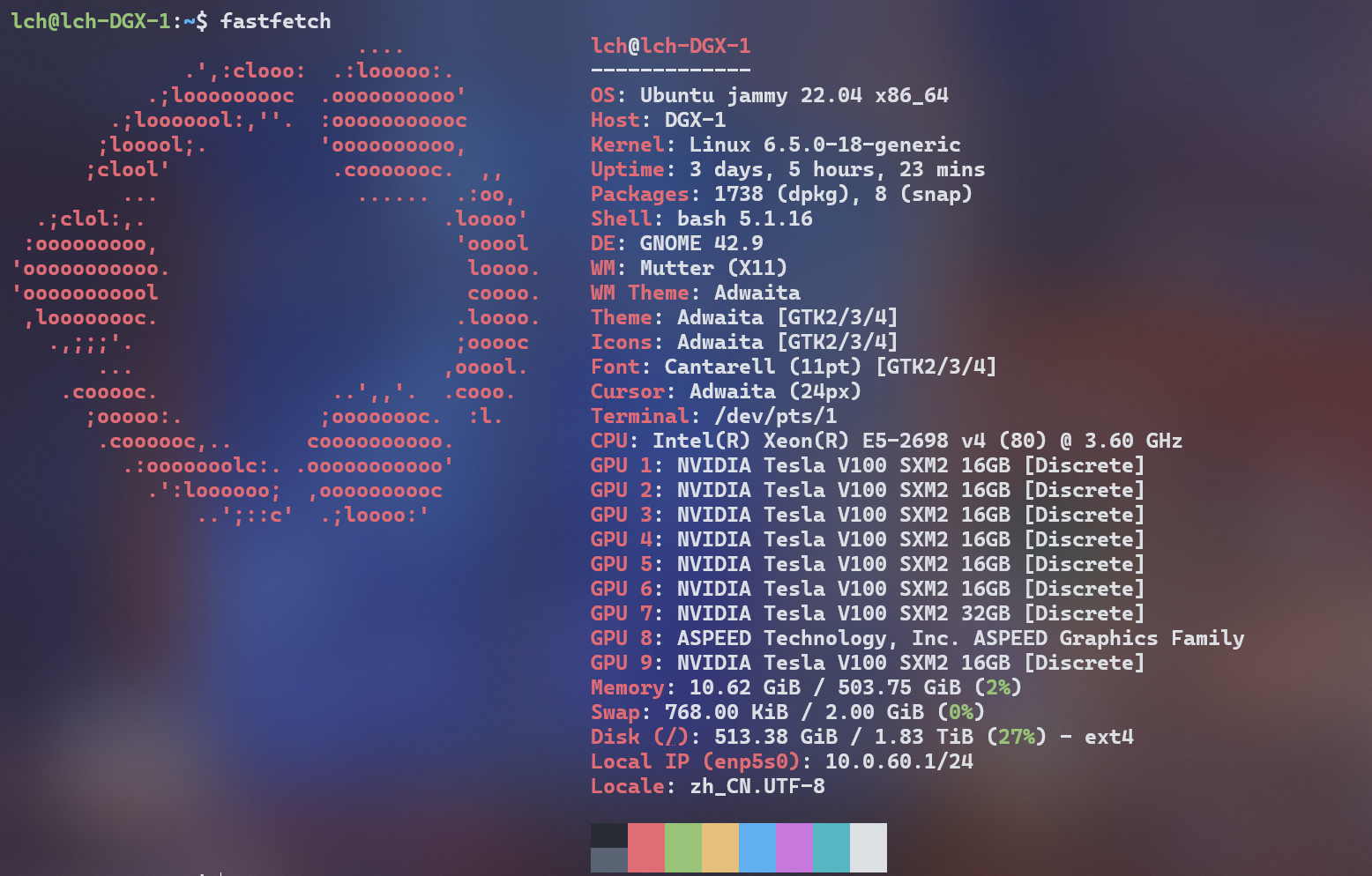

于是开始跑超大参数的大模型,目前用着最顺手的ollama部署,类似docker的命令,以及其专为推理所作的优化,太爱了

-

相关ollama模型下载问题

走的cloudflare,可以直连,速度很快

-

ollama外网调用的设置问题

-

Terminal window sudo vim /etc/systemd/system/ollama.service -

开始只设置了,Page Assist插件正常使用,以及openai-translator等原生支持ollama的正常使用

Terminal window Environment="OLLAMA_HOST=0.0.0.0:11434" -

后续提出需求,使用浏览器插件进行翻译,但openai-translator中只提供了openai的调用

-

查询资料了解到,ollama具有openai兼容性,详见(OpenAI 兼容性 - Ollama中文网)

-

于是乎,使用openai-translator的openai进行调用,无反应,无错误日志,换插件

-

查到该文章给沉浸式翻译插件配置本地大模型ollama服务 - 前端黑科技 - SegmentFault 思否,配置后出现错误代码403: fetchError,陷入盲区

-

在 LobeChat 中使用 Ollama · LobeChat Docs · LobeHub,拨雾见云,该文章中还配置了OLLAMA_ORIGINS,配置后使用openai调用方法的均正常工作,猜测该选项控制原生调用和openai调用(暂不确定,官方文档对此解释并不准确)

Terminal window [Service]Environment="OLLAMA_HOST=0.0.0.0:11434"Environment="OLLAMA_ORIGINS=*"

-

-

配置修改后执行

Terminal window systemctl daemon-reload #重载daemon文件systemctl start ollama #启动ollama服务 -

若仍未生效,则执行

Terminal window ps aux | grep ollama #查看当前运行的ollama进程kill PID

-

-

ollama的使用问题

使用浏览器插件

- Page Assist - 本地 AI 模型的 Web UI - Chrome 应用商店 (google.com)

- openai-translator/openai-translator: 基于 ChatGPT API 的划词翻译浏览器插件和跨平台桌面端应用 - Browser extension and cross-platform desktop application for translation based on ChatGPT API. (github.com)

- 沉浸式翻译 - 双语对照网页翻译插件 | PDF翻译 | 视频字幕翻译 (immersivetranslate.com)(强力推荐,双语对照,非常好用)

-

ollama模型文件目录

/usr/share/ollama/.ollama/models/blobs把别的地方下载好的ollama文件丢过去就行。

可以用python开个http服务器

python -m http.server 8088 --bind 0.0.0.0然后wget直接拉整个文件夹

wget -r -np -N -nH --cut-dirs=1 http://10.0.8.222:8088/